DeepSeek-R1は、DeepSeekが2025年1月20日にリリースした大規模言語モデルである。特に数学、プログラミング、論理的な思考などのタスクに適しており、その性能はOpenAI o1並みである。

OpenAIのGPTシリーズのような知識に基づいて応答を返す物はDeepSeek-Vシリーズで提供していて、DeepSeek-RシリーズはOpenAI oシリーズと同様に論理的思考力を強化したものである。

訓練費用

DeepSeek-R1の論文では、その訓練費用などの詳細は公開されていない。

DeepSeek-V3 Technical Reportでは、DeepSeek-V3をDeepSeekは米国の輸出規制により中国市場向けに特別供給されたNVIDIA H800を2048枚使用して訓練を行ったことを明らかにしており、実際はNVIDIA H800を購入しているが、訓練時間は合計278.8万時間だったので、$2/時間でレンタルしたと換算すると、訓練費用は557.6万ドルであり、類似のアメリカ企業のクローズドモデルよりもはるかに安い。Technical Reportでも書かれているが、あくまでも計算機を動かした時間の費用だけであり、それ以外にも様々な費用がかかっている。

API

DeepSeek-R1はMITライセンスでオープンソース化されており、誰でも自由にこのモデルを使用することができる。これには商業利用も含まれる。ユーザーはDeepSeekの公式ウェブサイトとアプリで、公式が提供するサービスを利用できる。

DeepSeek-R1の公開時に提供されたAPIサービスの価格は、入力トークン100万個あたり$0.14(キャッシュヒット時)/ $0.55(キャッシュミス時)、出力トークン100万個あたり$2.19であり、出力トークンの価格はOpenAI o1($60.00)のわずか3.65%である。

Hugging Face、GitHub Models、Azure AI Foundry、Amazon Web Servicesなどでも利用可能である。

GitHub ModelsでもDeepSeek-R1の方がOpenAI o1よりも安価で、2025年2月1日現在、DeepSeek-R1はRate limit tierがHighに分類されているため、無償プランでも1日50回利用可能だが、OpenAI o1は無償では利用不可で、Microsoft Copilot Pro(月額$20)に契約している人でも1日8回に制限されている。

DeepSeek-R1をローカルで実行するには、合計800GB以上のGPUのメモリが必要であり、Amazon Web Servicesの場合は、NVIDIA H200(メモリ141GB)8枚で実行している。

モデル

- DeepSeek-R1-Zero - パラメータ数671B

- DeepSeek-R1 - パラメータ数671B

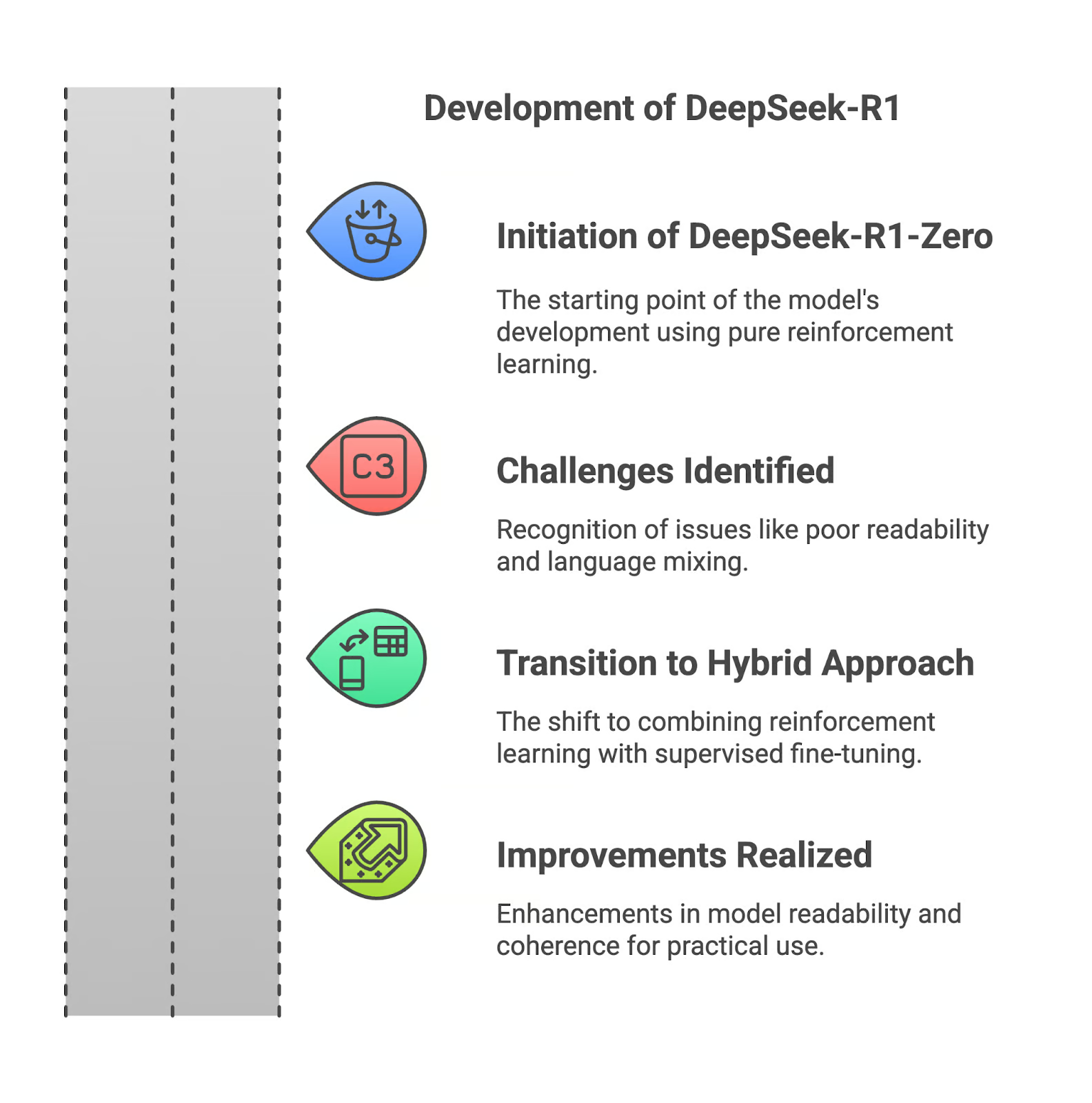

DeepSeek-R1-Zero と DeepSeek-R1 は DeepSeek-V3-Base を元に訓練されている。DeepSeek-R1-Zero は教師ありファインチューニングを行わずに、大規模強化学習だけで訓練されている。DeepSeek-R1 は強化学習の前にコールド・スタート・データを組み込むことで性能を改善したものである。

蒸留モデル

- Qwen

- DeepSeek-R1-Distill-Qwen-1.5B

- DeepSeek-R1-Distill-Qwen-7B

- DeepSeek-R1-Distill-Qwen-14B

- DeepSeek-R1-Distill-Qwen-32B

- Llama

- DeepSeek-R1-Distill-Llama-8B

- DeepSeek-R1-Distill-Llama-70B

ベンチマークでは、数学やプログラミングの課題において、DeepSeek-R1-Distill-Qwen-32BやDeepSeek-R1-Distill-Llama-70BはOpenAI o1-mini並みの性能がある。パラメータはbfloat16(2バイト)なので、これらは、NVIDIA H200(メモリ141GB)1枚で実行可能である。

パラメータ数が少ないものであれば普通のパソコンで動作し、LM Studioなどが利用可能である。

出典

関連項目

- DeepSeek

- OpenAI o1

外部リンク

- DeepSeek-R1 - GitHub

![[EAI024] DeepSeekR1 技术报告解读_datamondayDeepSeek技术社区](https://i-blog.csdnimg.cn/direct/8309863d19464a96adb5133f8cb23370.png#pic_center)